Eines gleich vorweg: Die Meldung, dass autonom fahrende Autos möglicherweise ein eingebautes Rassimusproblem haben, ist mitnichten ein ebenso verfrühter wie geschmackloser Aprilscherz, sondern das Ergebnis der Studie „Predictive Inequity in Object Detection“. des renommierten Georgia Institute of Technology. Wie kommen die US-Wissenschaftler in ihrer Untersuchung zu dieser „bemerkenswerten“ Erkenntnis, die sich aufs erste Hören irgendwie nach einer Botschaft aus Absurdistan anhört. Oder ist da am Ende wirklich was dran?

Kurz und knapp: Inhalt und Ergebnisse der Untersuchung

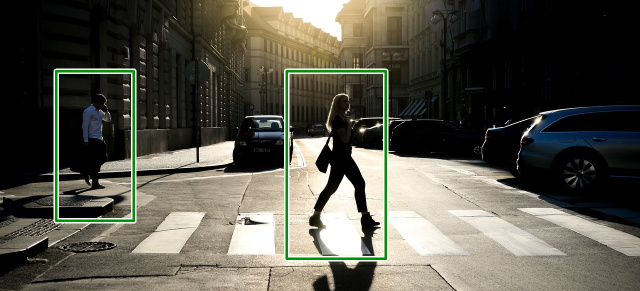

Die frisch veröffentlichte Studie stellt fest, dass die intelligenten Systeme selbstfahrender Autos zu Zwecken der Unfallvermeidung dunkelhäutige Fußgänger weniger gut erkennen würden als hellhäutige. Weitergedacht bedeutet dies, dass dunkelhäutige Menschen ein größeres Risiko als hellhäutige Menschen haben, von einem autonomen Fahrzeug angefahren und verletzt zu werden. Die Forscher haben festgestellt, dass, unabhängig von den Licht- und Sichtverhältnissen, die Erkennungsrate von dunkelhäutigen Menschen fünf Prozentpunkte unter der von hellhäutigen gelegen habe. Zur Erklärung dieses Ergebnisses verweisen die Wissenschaftler nicht auf ein technisches Problem, sondern auf den auch aus anderen Bereichen bekannten Effekt der so genannten algorithmische Neigung.

Man möchte ja meinen, dass ein Algorithmus an sich unparteiisch und unideologisch wäre. Doch das ist er zuweilen eben nicht. Die algorithmische Neigung hat - so die Wissenschaftler der Studie - in diesem Fall hauptsächlich zwei Gründe. Zum einen würde die persönliche Haltung/Präferenz der Softwareentwickler ihren Niederschlag in den Programmen zur Steuerung der Systeme finden. Zum anderen hätten die Untersuchungen ergeben, dass die Modelle zur Objekterkennung, welche den Wissenschaftler zur Auswertung zur Verfügung standen, überwiegend an hellhäutigen Menschen trainiert worden seien und die zahlmäßig geringeren Trainings mit dunkelhäutigen Menschen in der Programmierung zum Ausgleich nicht stärker gewichtet

![]()

„Predictive Inequity in Object Detection“.pdf

1.86 MB

worden wären. Im Endeffekt würde es dann - ob gewollt oder nicht - de facto zur Programmierung einer Fußgängererkennung mit Tendenz zur Ungleichheit kommen, welche die Wissenschaftler als „Rassismusproblem bezeichnen. Klingt irgendwie seltsam, ist aber hier so und lässt sich auf Mercedes-Fans.de von jedem Mann und jeder Frau und jedem Diversen gleich welcher Nationalität und Hautfarbe in den in englischer Sprache veröffentlichten Ergebnissen der Studie „Predictive Inequity in Object Detection“ als downloadbares PDF anklicken und nachlesen.

Autor: Mathias Ebeling

Keine Kommentare

Schreibe einen Kommentar